Cookiecutterを使ってテンプレートからプロジェクトを作成する

皆さんこんにちは

お元気ですか。ユニクロの極暖Tシャツ着ているとかなり暑い。。。冬なのに

今日は、Cookiecutterを使ったテンプレートからの複製生成を試みます。

テンプレートからちょっと変えたい部分を用意することで、簡単に

似たプロジェクトを作成できます。

Cookiecutterについて

Cookiecutterは雛形となるテンプレートプロジェクトから

プロジェクトを生成するツールです。

雛形となるプロジェクトを作ってしまえば、少し変更したい箇所を指定して

新しいプロジェクトを作ります。

Cookiecutterを使った複製をやってみる。

頻繁に利用がありそうなテンプレートの雛形は既に用意されています。

とりあえず、何も考えずに作ってみましょう。

GitHub - ionelmc/cookiecutter-pylibrary: Enhanced cookiecutter template for Python libraries.の雛形を使用する場合は

次のように実行します。

cookiecutter gh:ionelmc/cookiecutter-pylibrary

途中で色々と聞かれるので必要のある箇所は入力します。

full_name [Ionel Cristian Maries]: tereka email [contact@ionelmc.ro]: website [https://blog.ionelmc.ro]: github_username [ionelmc]: project_name [Nameless]: repo_name [python-nameless]: package_name [nameless]: distribution_name [nameless]: project_short_description [An example package. Generated with cookiecutter-pylibrary.]: release_date [today]: Select year: (略)

他にもflaskやdjango、restのプロジェクトがあります。

これで、確認すると変数となっていた箇所が指定した名前に

置き換わっていることを確認できます。

次はテンプレートを構築してみます。

テンプレートを作成に挑戦してみる。

準備されているテンプレートでは不足することもあるでしょう。

そんなときのために、自分で1からテンプレートを作ってみます。

ディレクトリの雛形は以下の通りです。

ディレクトリ構成

treeコマンドを使ってcookiecutterの雛形の構成を表示します。

.

└── TestProject

├── cookiecutter.json

└── {{cookiecutter.project_name_lower}}

└── README.md

cookiecutter.json

cookiecutter.jsonにcookiecutterの雛形で使う変数を定義します。

{ "project_name" : "test-project", "create_document": "y", "license": ["MIT", "BSD-3", "GNU GPL v3.0", "Apache Software License 2.0"], "project_name_rower" : "{{ cookiecutter.project_name|replace('-', '_') }}" }

{{ cookiecutter.<変数名> }}とすることで、その変数を埋め込めます。

また、埋め込んだ変数の文字を"-"→"_"に置換しています。

licenseの箇所はリストにしています。リストをjsonで入力した場合、

対話的に実行する時に候補を表示します。

README.md

プロジェクト内にあるREADME.mdにcookiecutterで

定義した変数を埋め込むテストをします。

今回、テストとして用意した文書は以下の通りです。

{{ cookiecutter.project_name}} document.

{% if cookiecutter.create_document == 'n' -%}

No Document

{%- endif %}

{% if cookiecutter.create_document == 'y' -%}

{{cookiecutter.license}}

This is an apple.

{%- endif %}このREADME内で、cookiecutterの変数を使えることは同じです。

追加で、if文を使った条件式を構築できます。上記の場合、

{% if cookiecutter.create_document == 'n' -%}はcreate_document変数がnの場合に動作し、

{% if cookiecutter.create_document == 'y' -%}はcreate_document変数がyの場合に動作します。

実行

コマンドラインからcookiecutter <ディレクトリ>で実行できます。

但し、ディレクトリ内にcookiecutter.jsonがないと実行できません。

$ cookiecutter TestProject/ project_name [test-project]: test-project create_document [y]: y Select license: 1 - MIT 2 - BSD-3 3 - GNU GPL v3.0 4 - Apache Software License 2.0 Choose from 1, 2, 3, 4 [1]: 2 project_name_lower [test_project]:

cookiecutter.jsonにリストで定義した設定は番号で選択できるようになっています。

作られたプロジェクトを確認する

最後に作ったプロジェクトを確認します。

まず、cookiecutterの変数になっていたディレクトリが

「test_project」の名前になりました。

.

└── test_project

└── README.md

README.md

test-project document. BSD-3 This is an apple.

README.mdを見ると、変数名が埋め込まれています。(test-project)

また、create_documentの条件が"n"となっている箇所が表示されていないことを確認できます。

更に、条件式が"y"の時に表示される文章を確認できました。

最後に

cookiecutterを使うと、基本となる雛形から

オリジナルのプロジェクトを簡単に作成できます。

ちょっとだけ変えたプロジェクトを作成したいことは結構あります。

意外に応用できそうなので、もっと使ってみたいと感じています。

Visual Studio CodeでC++の環境構築をやってみる

皆さんこんにちは

お元気ですか。私は元気です。

VIsual Studio CodeでC++の環境を構築します。

C++のコードを書く時に案外いいエディタがなくて結構困ります。

今まではsublime text+ pluginを使っていましたが、デバッガ厳しい、

補完難しいなど色々困っていました。

そこで、試しにVisual Studio CodeでC++の環境を作ってみました。

Visual Studio Code

Microsoftが作っているWindows, MacOS, Linuxで動作する

軽量高速な高機能エディタです。

(Visual Studio Code - Visual Studioより)

ダウンロードは次のサイトを参考にしてください。

code.visualstudio.com

設定方法

まずは、Visual Studio CodeにC++の環境を構築します。

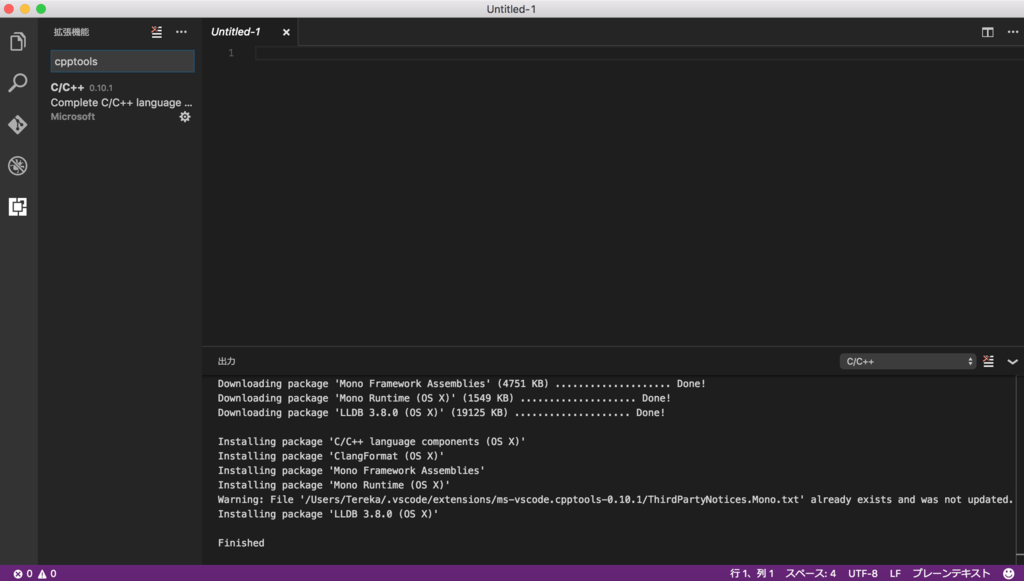

C++の開発機能であるcpptoolsを拡張機能(plugin)からインストールします。

その手順は次の通りです。

- Visual Studio Codeを開く

- 左から拡張機能を選択する。

- cpptoolsを検索する。

- インストールする。

Visual Studio Codeと色々な機能

前準備

ソースコードを準備します。他にも設定ファイルなどが必要なものはありますが、

それは適宜、準備していきます。

#include <iostream> using namespace std; int main(void){ int a = 10; int b = 20; int c = a + b; cout << c << endl; return 0; }

コンパイルをする

コンパイルのショートカットキーは「cmd + shift + b」を使うと可能です。

ただ、タスクランナーがないと出るので、「tasks.json」を作るように言われます。

そのため、tasks.jsonを設定します。tasks.jsonにはg++のコマンドを設定します。

{ // See https://go.microsoft.com/fwlink/?LinkId=733558 // for the documentation about the tasks.json format "version": "0.1.0", "command": "g++", "isShellCommand": true, "args": ["-O2", "-g", "test.cpp"], "showOutput": "always" }

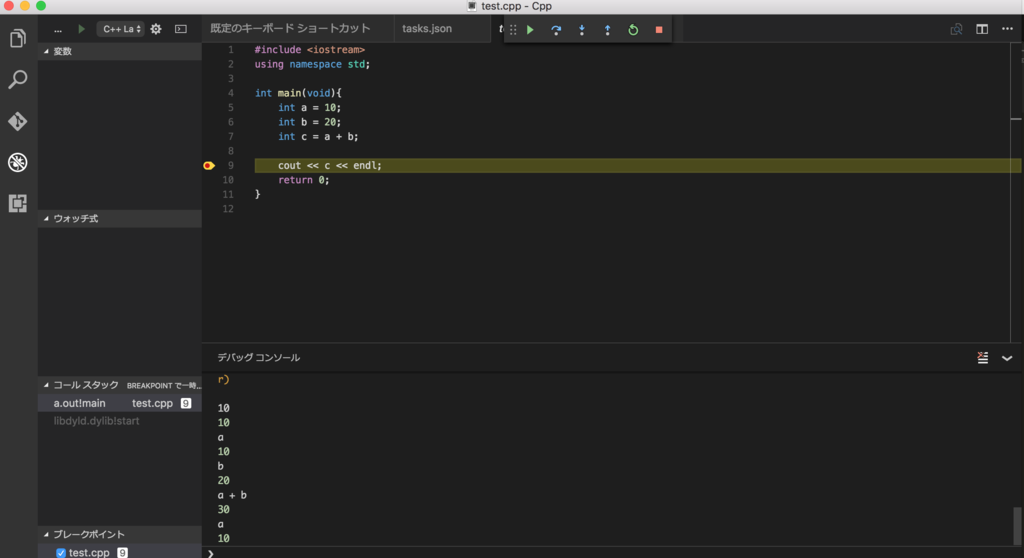

デバッグ

Debugタブから起動すると、「launch.json」が作られます。

起動するためには、launch.jsonの修正が必要です。

"program"の値を以下に変更が必要です。この"program"は

実行ファイルのパスを記述します。

"program": "${workspaceRoot}/a.out",デバッグは以下のような画面で、gdbが使われます。

予め、break pointを仕掛けるとその箇所で止まります。

実際にデバッグすると次のような画面になります。

ヘッダーの設定

コマンドで、「C/Cpp: Edit Configurations」を選択すると

C++の設定ファイル「「c_cpp_properties.json」が作られます。

そのの内部にヘッダーを設定する箇所があるので、その箇所にヘッダーのパスを

設定をすると読み込みすることができます。

このファイルはOS別に設定ができるため、該当するOSの"includePath"を変更します。

"includePath": [ "/usr/include", "/usr/local/include" ],

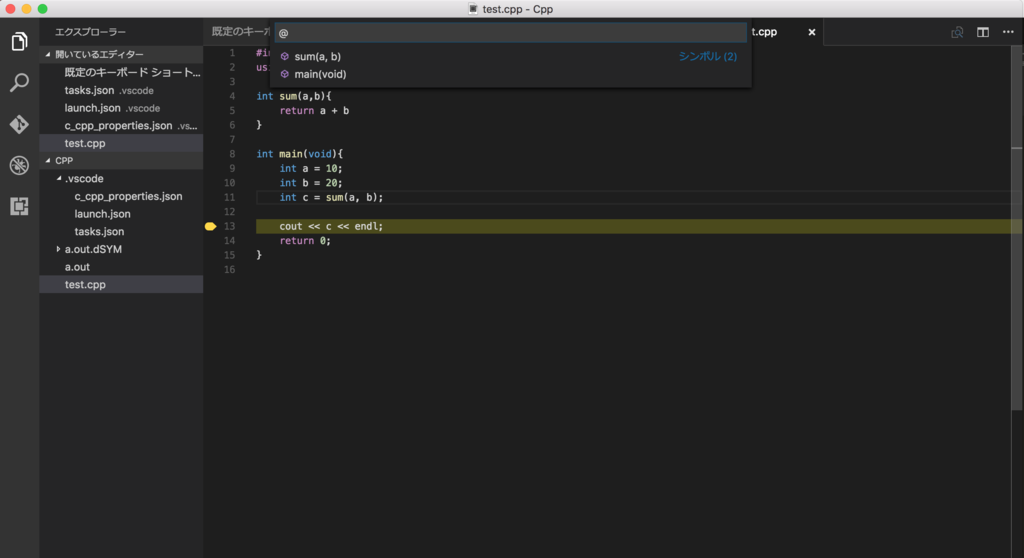

関数検索

関数検索は「cmd + shift + O」を使えばできます。

後はその欄で該当するファイルを探しましょう。

最後に

C++のエディタで良いものがなかったので、これはいい感じだと思っています。

Dockerを使ってGPUも使える分析環境を構築してみた

皆さんこんにちは

お元気ですか。Kaggle Meetup面白かったです!またあいましょう。

今日はDockerを使った分析環境構築の話をしようと思います。

Dockerを使って何を作ろうかと思ったら、分析環境さっさと作りたい・・・

cudnn等の更新が面倒であることが思い浮かびました。

なんとなく、Dockerを使えば解消できるのではないかといったことを思いつき遊んでみました。

Dockerとは

Dockerはコードやシステムライブラリ、システムで利用するのを実行するために

必要な全てが含まれているものをラップするソフトウェアらしい。

OS上で仮想環境を立ち上げ、ソフトウェアなどの実行ができます。

Dockerのメリット

公式サイトによれば、次のとおりです。

何が嬉しいの?

一言で言うと環境の管理です。

Dockerを使うと定義したコマンドを変更するのみで

ソフトウェアの更新が簡単になります。

また、同じファイルを利用している限り、同じ環境が構築されるので

マシンによってversionなどの差分が生まれることもなくなります。

私個人として大きいのは環境の再現だと思っています。

誰もがDockerを使うと同じバージョン、同じ環境を手間なく使えます。

更新手順と同じにしておけば、複数人で開発しても環境が同じ等、メリットがあります。

インストール

MacOS

これを試すためにだけ、Sierraにアップグレードしました。

Docker for macをダウンロードし、インストールすれば、準備完了です。

docs.docker.com

Ubuntu

MacOSと違って手順が少々必要です。(公式より)

sudo apt-get install apt-transport-https \ ca-certificates curl -fsSL https://yum.dockerproject.org/gpg | sudo apt-key add - sudo apt-get install software-properties-common sudo add-apt-repository \ "deb https://apt.dockerproject.org/repo/ \ ubuntu-$(lsb_release -cs) \ main" sudo apt-get update sudo apt-get -y install docker-engine

dockerを試してみる。

まずは、dockerのイメージを取得します。

pullコマンドはイメージをダウンロードするコマンドです。

docker pull ubuntu:16.04

次にDockerを実行します。実行コマンドはrunを使えばできます。

docker run -it ubuntu:16.04

root@fe9c5c38a45a:/#

そして、共有フォルダです。

ホストとコンテナのディレクトリを共有できます。

これは、-vを利用するとマウントが可能です。<ホスト側のパス>:<コンテナ側のパス>を記述して起動することで実現できます。

docker run -v /Users/Tereka/Desktop/Mount:/tmp/ -it ubuntu:16.04

また、Imageの一覧を確認するには、次のコマンドを使うと良いです。

$ docker images REPOSITORY TAG IMAGE ID CREATED SIZE ubuntu 16.04 104bec311bcd 2 weeks ago 129 MB hello-world latest c54a2cc56cbb 6 months ago

dockerのコンテナ状態は次のコマンドで見れます。

$ docker ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES e09f51e1b51c ubuntu:16.04 "/bin/bash" 3 hours ago Up 7 minutes

最後にコンテナの削除です。rmiコマンドを使うと可能です。

docker rmi <contener>:<tag>

どのようなimageがあるのかを検索したい時は、docker search

これを使うとpullで取得できるコンテナを探せます。

$ docker search centos NAME DESCRIPTION STARS OFFICIAL AUTOMATED centos The official build of CentOS. 2963 [OK] jdeathe/centos-ssh CentOS-6 6.8 x86_64 / CentOS-7 7.3.1611 x8... 54 [OK] nimmis/java-centos This is docker images of CentOS 7 with dif... 20 [OK] million12/centos-supervisor Base CentOS-7 with supervisord launcher, h... 12 [OK] torusware/speedus-centos Always updated official CentOS docker imag... 8 [OK]

Dockerfileを書く

Dockerfileを書くことで、独自のイメージを作れます。

FROMを利用すると、他のイメージをベースにDockerイメージをベースに構築できます。

RUNを利用することで、実際にコマンドの実行ができます。

説明するよりも見る方が早いかと。

試しにChainerを実行するDockerfileを作りました。

日本語入力にも対応しているコンテナです。

FROM nvidia/cuda:7.5-cudnn5-devel RUN apt-get update RUN apt-get install -y wget RUN apt-get -y install language-pack-ja-base language-pack-ja ibus-mozc RUN update-locale LANG=ja_JP.UTF-8 LANGUAGE=ja_JP:ja ENV LANG ja_JP.UTF-8 ENV LC_ALL ja_JP.UTF-8 ENV LC_CTYPE ja_JP.UTF-8 RUN wget https://repo.continuum.io/archive/Anaconda3-4.2.0-Linux-x86_64.sh RUN bash Anaconda3-4.2.0-Linux-x86_64.sh -b ENV PATH /root/anaconda3/bin:$PATH RUN echo $PATH RUN pip install chainer

以下のコマンドはDockerfileをビルドし、cudnn_dockerの名前で新しいイメージを構築しています。

docker build -t cudnn_chainer .

途中で失敗すると既に実行された結果のキャッシュを使います。

そのため、修正して再トライするのは非常に早いです。

ただし、それまでの結果を更新したい(gitのリポジトリの最新を使いたい等)

結果のキャッシュを使いたくない場合は、キャッシュを無効にしなければなりません。

その場合は、以下のコマンドを使うとDockerfileに書いてある

全てのコマンドを対象にbuildを行います。

docker build -t --no-cache=true cudnn_chainer .

後はrunを使えば実行できます。

docker run -it cudnn_chainer

DockerでGPUを使う方法

しかし、これではGPUを使うとエラーが出ます。

GPUをDockerコンテナ上で動かす為にはGPUの色々な設定をする必要があるようです。

chainerの公式githubを確認すると、nvidia-dockerと呼ばれるコマンドがあるので

それを使うと解消できました。因みにnvidia-dockerリポジトリは以下にあります。

まずは、インストールですが、以下のとおりです。

wget -P /tmp https://github.com/NVIDIA/nvidia-docker/releases/download/v1.0.0/nvidia-docker_1.0.0-1_amd64.deb sudo dpkg -i /tmp/nvidia-docker*.deb && rm /tmp/nvidia-docker*.deb # 起動確認 nvidia-docker run --rm nvidia/cuda nvidia-smi

後は起動するだけです。起動はdockerの代わりにnvidia-dockerを使います。

試しに遊んでみたら高速だった。僕のcudnnが古すぎた。。

nvidia-docker run -it cudnn_chainer

最後

これで一通りDockerを扱える気がします。

気が向いたらもう応用できそうな記事を書きます。

2017年の挨拶とやりたいこと

あけましておめでとうございます。

今年もよろしくお願いします。

ふりかえりはしませんが、昨年はエキサイティングな1年間で色々なことに

挑戦していった年でした。

色々と課題も見えてきましたが・・・

今年はKaggleもしかりお仕事もしかり色々やっていったかなと思います。

結局、Kaggle Masterになれず、Competitions Expertにいます。

今年こそはなりたいなぁ

やりたいこと

今年度もやりたいことは沢山あります。

- 強化学習の勉強

- 数学の勉強

- Docker等の環境構築周りの勉強

- PyConJPへの登壇挑戦

色々な分野に強化学習を+αとする研究や論文が増えていると感じています。

本を読んで、勉強を進めたいと思います。

せめて、基本的なところがわかるようになりたい。

- 作者: 牧野貴樹,澁谷長史,白川真一,浅田稔,麻生英樹,荒井幸代,飯間等,伊藤真,大倉和博,黒江康明,杉本徳和,坪井祐太,銅谷賢治,前田新一,松井藤五郎,南泰浩,宮崎和光,目黒豊美,森村哲郎,森本淳,保田俊行,吉本潤一郎

- 出版社/メーカー: 森北出版

- 発売日: 2016/10/27

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (2件) を見る

数学についても今年は行列演算を復習したり、ベースとなる知識を増やしたりしたいと思います。

加えて機械学習プロフェッショナルシリーズも読みたい。

- 作者: Philip N. Klein,松田晃一,弓林司,脇本佑紀,中田洋,齋藤大吾

- 出版社/メーカー: オライリージャパン

- 発売日: 2016/10/05

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (2件) を見る

カーネル多変量解析―非線形データ解析の新しい展開 (シリーズ確率と情報の科学)

- 作者: 赤穂昭太郎

- 出版社/メーカー: 岩波書店

- 発売日: 2008/11/27

- メディア: 単行本

- 購入: 7人 クリック: 180回

- この商品を含むブログ (32件) を見る

更に、最近ではDockerなどによる分析基盤構築話を

時折Qiitaで見ます。そこで、少なくともDocker等を自分で

触れるようにしたいなぁなんて考えています。

最後に、PyConJPの登壇も目指したいなぁと思っています。

去年は聴衆として参加しましたが、せっかくだから話すネタを作って挑戦したいです。

(マーフィーなんて忘れた)

今年の記事

今年は何をメインに書こうかなぁと実家で考えていましたが、

去年と同じく、やったことを書いていくような感じになるでしょう。

去年は分野が結構偏っていたなぁと自分自身でも思っています。

機械学習・データ分析のみならず、色々と自由に書いていきたいと思います。

その結果、分野が偏ってしまった場合はご愛嬌ということで・・・

最後に

改めまして、皆様、今年もよろしくお願いします。

クリスマスにもなってカノジョがいないからカノジョを作ってみた。

皆さんこんにちは

お元気ですか?私はぼっちです。

本記事は「カノジョできない機械学習エンジニア」の最終日です。

qiita.com

本日の話の流れは次のとおりです。

はじめに

カノジョがいなくて寂しい。こんなクリスマスを送る男性の皆様は結構いらっしゃるのでは

ないでしょうか(と信じたい)。

カノジョを作るために、世間でよく言われるのは「行動が大事だ」ということです。

そこで、本クリスマスを機に、カノジョを作成し心の溝を埋めることに挑戦したいと思います。

カノジョがいないことに対する解決法

「カノジョ」がいないのであれば、作れば良い。

私はエンジニアです。

寂しいので、これを機に自己を振り返り、カノジョを作れるのではないかと考えました。

まずは、「カノジョ」を設計する必要があります。

カノジョについての考察

カノジョとは

「デジタル大辞泉」には次の通り記載されている。

[代]三人称の人代名詞。話し手、相手以外の女性をさす語。「彼女は遅れるらしい」⇔彼/彼氏。

[名]愛人、恋人である女性。「彼女ができた」⇔彼/彼氏。

本記事では、「愛人、恋人である女性」と仮定し話を進めましょう。

理想のカノジョとは

理想のカノジョとは何か。

クリスマスといえば、やっぱりクリスマスデートして・・というのが

定番かなぁと思います。

デートで大事なのは、会話かなと思います。やっぱり盛り上がる方が良いでしょう。

そこで理想のカノジョは会話が最も大事だと今回仮定します。

理想のカノジョ作成方針

会話が最も大事だと決めた上で理想のカノジョを作る必要があります。

調べてみると、ニューラルネットワークを使った会話モデルがありました。

カノジョを作成する。

さて、本題です。カノジョを作ってみます。

Neural Conversational Model

「A Neural Conversational Model」を使って実装します。

概要

Neural Conversational Modelは会話モデルです。

基本的な構造はseq2seqと類似しており、

入力は最初の文章、期待結果は返す文章(応答文)です。

構成解説

構成を図にしました。入力は次のとおりになります。

- 学習時:最初に与えた文章(質問文or話しかける文章)+ 応答文

- 予測時:最初に与えた文章

最初の文章と返す文章を入力に与えて学習します。

次は上記構成の動作についてです。

まずは、ニューラルネットワークの学習です。

与えたIDにもとづきEmbeded Layerからベクトルを取得します。

このベクトルをLSTMに与えます。また、次の単語とそれまでのLSTMの値を入力とし、LSTMを更新します。

これを

また、最後のLSTMの値を使って計算したベクトルを最後に

Linearで予測単語を計算します。予測単語との誤差を計算し、誤差を最小にする動作を行います。

入力のLSTM(Long Short Term Memory)と出力のLSTMは別のLSTMです。

# coding:utf-8 from __future__ import absolute_import from __future__ import unicode_literals import chainer.links as L import chainer.functions as F import chainer import numpy as np from chainer import reporter class Seq2Seq(chainer.Chain): def __init__(self, input_words): super(Seq2Seq, self).__init__( word_vec=L.EmbedID(input_words, 300), input_vec=L.LSTM(300, 300), output_vec=L.LSTM(300, 300), output_word=L.Linear(300, input_words) ) self.train = True def encode(self, sentence): c = None for word in sentence: x = np.array([word], dtype=np.int32) h = F.tanh(self.word_vec(x)) c = self.input_vec(h) return c def decode(self, vector=None, targer_sentence=None, dictionary=None): loss = 0 if self.train: for index, target_word in enumerate(targer_sentence): if index == 0: j = F.tanh(self.output_vec(vector)) pred_word = self.output_word(j) else: j = F.tanh(self.output_vec(j)) pred_word = self.output_word(j) loss += F.softmax_cross_entropy(pred_word, np.array([target_word], dtype=np.int32)) return loss else: gen_sentence = [] cnt = 0 while True: if cnt == 0: j = F.tanh(self.output_vec(vector)) pred_word = self.output_word(j) else: j = F.tanh(self.output_vec(j)) pred_word = self.output_word(j) id = np.argmax(pred_word.data) cnt += 1 word = dictionary[id] if word == "<eos>": return gen_sentence gen_sentence.append(word) if cnt == 100: break return gen_sentence def generate_sentence(self, sentence, dictionary): self.initialize() encode_vector = self.encode(sentence=sentence) return self.decode(vector=encode_vector, dictionary=dictionary) def initialize(self): self.input_vec.reset_state() self.output_vec.reset_state() def __call__(self, sentence, target_sentence): self.initialize() encode_vector = self.encode(sentence=sentence) self.loss = None self.loss = self.decode(vector=encode_vector, targer_sentence=target_sentence) reporter.report({'loss': self.loss}, self) return self.loss

実装してみた

seq2seq2をChainerとRNN + LSTMで実装します。

今回はTrainerを使った実装にします。

データの構築

Step1 探す

どうやって構築するんだ。

家に「落第騎士の英雄譚」があったので参考にしました。

「黒鉄一輝」と「ステラ・ヴァーミリオン」の会話あたりを

中心に作成させていただいております。

落第騎士の英雄譚<キャバルリィ>【電子特装版】 (GA文庫)

- 作者: 海空りく

- 出版社/メーカー: SBクリエイティブ

- 発売日: 2013/10/17

- メディア: Kindle版

- この商品を含むブログを見る

Step2 存在しない言葉

存在しない言葉についてです。

形態素解析をした単語に対して、IDを振ります。

例えば次のようなことを想定しています。

| 単語 | ID |

| 私 | 0 |

| は | 1 |

| 猫 | 2 |

| だ | 3 |

しかし、この場合、未知語に対しての解析ができなくなります。

そのため、未知の単語が出てくれば「■」とします。(主に予測時ですね)

Step3 名前

人は名前を呼ばれると嬉しいものです。

ただ、名前は皆さん別々のをお持ちのため、名前と呼ばれる概念で学習します。

今回、呼ばれたい側の名前は全て「◯」へ置き換えておきます。

これはSlackbotへのリプライ段階で「◯」を名前に置換します。

学習する

さて、ここまでで準備ができました。

早速、学習を行います。今回はTrainerを使った学習を用いているため、一部の

更新方法を自分で実装しています。

テキストファイルにタブ区切りのドキュメントを用意し、それを対にして学習させています。

# coding:utf-8 import MeCab from model import Seq2Seq from chainer import training import chainer from chainer.training import extensions import numpy as np import sys import codecs import json sys.stdout = codecs.getwriter('utf_8')(sys.stdout) tagger = MeCab.Tagger('mecabrc') def parse_sentence(sentence): parsed = [] for chunk in tagger.parse(sentence).splitlines()[:-1]: (surface, feature) = chunk.split('\t') parsed.append(surface.decode("utf-8")) return parsed def parse_file(filename): questions = [] answers = [] with open(filename, "r") as f: lines = f.readlines() for line in lines: sentences = line.split("\t") question = ["<start>"] + parse_sentence(sentences[0]) + ["<eos>"] answer = parse_sentence(sentences[1]) + ["<eos>"] questions.append(question) answers.append(answer) word2id = {"■": 0} id2word = {0: "■"} id = 1 sentences = questions + answers for sentence in sentences: for word in sentence: if word not in word2id: word2id[word] = id id2word[id] = word id += 1 return questions, answers, word2id, id2word def sentence_to_word_id(split_sentences, word2id): id_sentences = [] for sentence in split_sentences: ids = [] for word in sentence: id = word2id[word] ids.append(id) id_sentences.append(ids) return id_sentences class ParallelSequentialIterator(chainer.dataset.Iterator): def __init__(self, dataset, batch_size, repeat=True): self.dataset = dataset self.batch_size = batch_size # batch size self.epoch = 0 self.is_new_epoch = False self.repeat = repeat self.iteration = 0 def __next__(self): length = len(self.dataset[0]) if not self.repeat and self.iteration * self.batch_size >= length: raise StopIteration batch_start_index = self.iteration * self.batch_size % length batch_end_index = min(batch_start_index + self.batch_size, length) questions = [self.dataset[0][batch_index] for batch_index in range(batch_start_index, batch_end_index)] answers = [self.dataset[1][batch_index]for batch_index in range(batch_start_index, batch_end_index)] self.iteration += 1 epoch = self.iteration * self.batch_size // length self.is_new_epoch = self.epoch < epoch if self.is_new_epoch: self.epoch = epoch return list(zip(questions, answers)) class BPTTUpdater(training.StandardUpdater): def update_core(self): loss = 0 train_iter = self.get_iterator('main') optimizer = self.get_optimizer('main') batch = train_iter.__next__() for question, answer in batch: loss += optimizer.target(np.array(question, dtype=np.int32), np.array(answer, dtype=np.int32)) optimizer.target.cleargrads() loss.backward() loss.unchain_backward() optimizer.update() if __name__ == '__main__': questions, answers, word2id, id2word = parse_file("./dataset.txt") ids_questions = sentence_to_word_id(questions, word2id=word2id) ids_answers = sentence_to_word_id(answers, word2id=word2id) model = Seq2Seq(len(word2id)) optimizer = chainer.optimizers.Adam() optimizer.setup(model) train_iter = ParallelSequentialIterator(dataset=(ids_questions, ids_answers), batch_size=1) updater = BPTTUpdater(train_iter, optimizer) trainer = training.Trainer(updater, (100, 'epoch')) trainer.extend(extensions.PrintReport( ['epoch', 'iteration', 'main/loss'] ), trigger=(100, 'iteration')) trainer.extend(extensions.LogReport()) trainer.run() chainer.serializers.save_npz("model.npz", model) json.dump(id2word, open("dictionary_i2w.json", "w")) json.dump(word2id, open("dictionary_w2i.json", "w"))

Slack Botで実用化する

これまで作成したカノジョを実用化します。

SlackでBotを作れるので、そこで展開を試みました。

Botをコントロールするコード

ソースコードを記載する前にPythonのSlackbotをコントロールするライブラリが必要です。

Pythonのライブラリは次のようにインストールできます。

pip install slackbot

まずは、slackbot_settings.pyにAPI Keyを記述します。

#coding:utf-8 API_TOKEN = "YOUR API KEY"

run.pyに動作させたいコードを記述します。

動作させたいコードに対してデコレータを使います。

そのコードに対して、@default_replyを付与します。

reply_messageにこのデコレータを付与すると指定のない場合はこのメソッドが使われる設定になります。

sentence.replace("◯", "tereka")を使って、名前を途中で置換しています。

これで自分の名前が呼ばれます!やったね。

# coding:utf-8 import MeCab import codecs from slackbot.bot import default_reply from slackbot.bot import Bot from model import Seq2Seq import chainer import json import sys sys.stdout = codecs.getwriter('utf_8')(sys.stdout) tagger = MeCab.Tagger('') id2word = json.load(open("dictionary_i2w.json", "r")) id2word = {int(key): value for key, value in id2word.items()} word2id = json.load(open("dictionary_w2i.json", "r")) model = Seq2Seq(len(word2id)) chainer.serializers.load_npz("model.npz", model) model.train = False @default_reply def replay_message(message): parsed_sentence = [] try: for chunk in tagger.parse(message.body["text"].encode("utf-8")).splitlines()[:-1]: (surface, feature) = chunk.decode("utf-8").split('\t') parsed_sentence.append(surface) parsed_sentence = ["<start>"] + parsed_sentence + ["<eos>"] ids = [] for word in parsed_sentence: if word in word2id: id = word2id[word] ids.append(id) else: ids.append(0) ids_question = ids sentence = "".join(model.generate_sentence(ids_question, dictionary=id2word)).encode("utf-8") sentence = sentence.replace("◯", "tereka") message.reply(sentence) except Exception as e: print (e) message.reply("解析できなかったのでもう一度おねがいします。") def main(): bot = Bot() bot.run() if __name__ == "__main__": main()

実際にどうなったのか

実際にチャットしてみました。

なんかちょっとだけ女の子とチャットしている気分になりました。

チャットしていてわかったのですが、リプライが短文なのはある程度、学習できている感覚があります。

特有の単語を学習してそうな気がしますが、やはりデータセットが少なすぎたか。

最後に

カノジョいなくて寂しい。

DeepLearningを使ったBotの作成に参考にしてみてください。